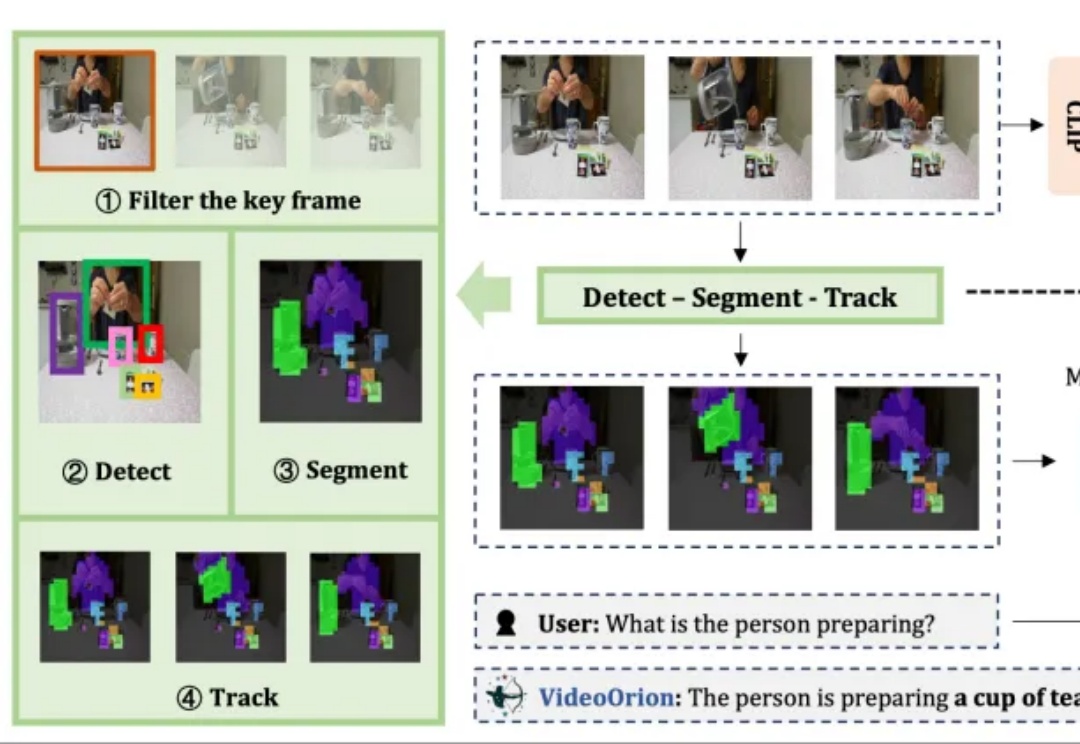

视频大模型新基元:用Object Tokens重塑细节感知与指代理解

视频大模型新基元:用Object Tokens重塑细节感知与指代理解被顶会ICCV 2025以554高分接收的视频理解框架来了!

被顶会ICCV 2025以554高分接收的视频理解框架来了!

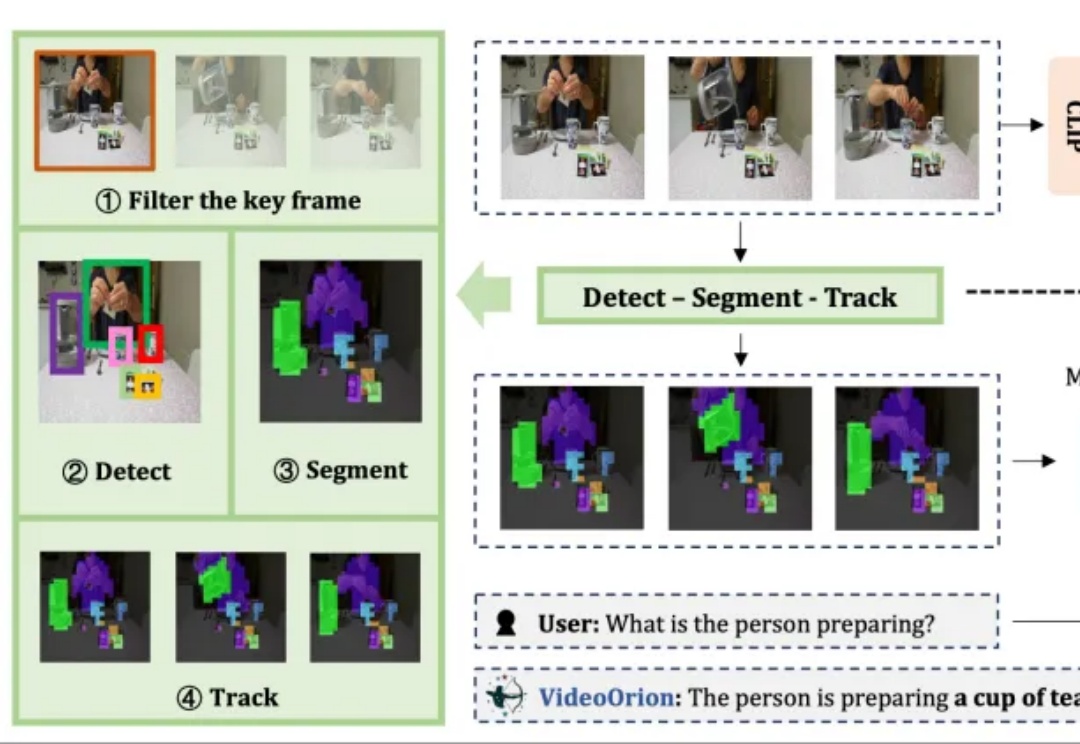

你是否曾为搭建具身仿真环境耗费数周学习却效果寥寥? 是否因人工采集海量交互数据需要高昂成本而望而却步? 又是否因找不到足够丰富真实的开放场景让你的智能体难以施展拳脚?

智能汽车、自动驾驶、物理AI的竞速引擎,正在悄然收敛—— 至少核心头部玩家,已经在最近的ICCV 2025,展现出了共识。

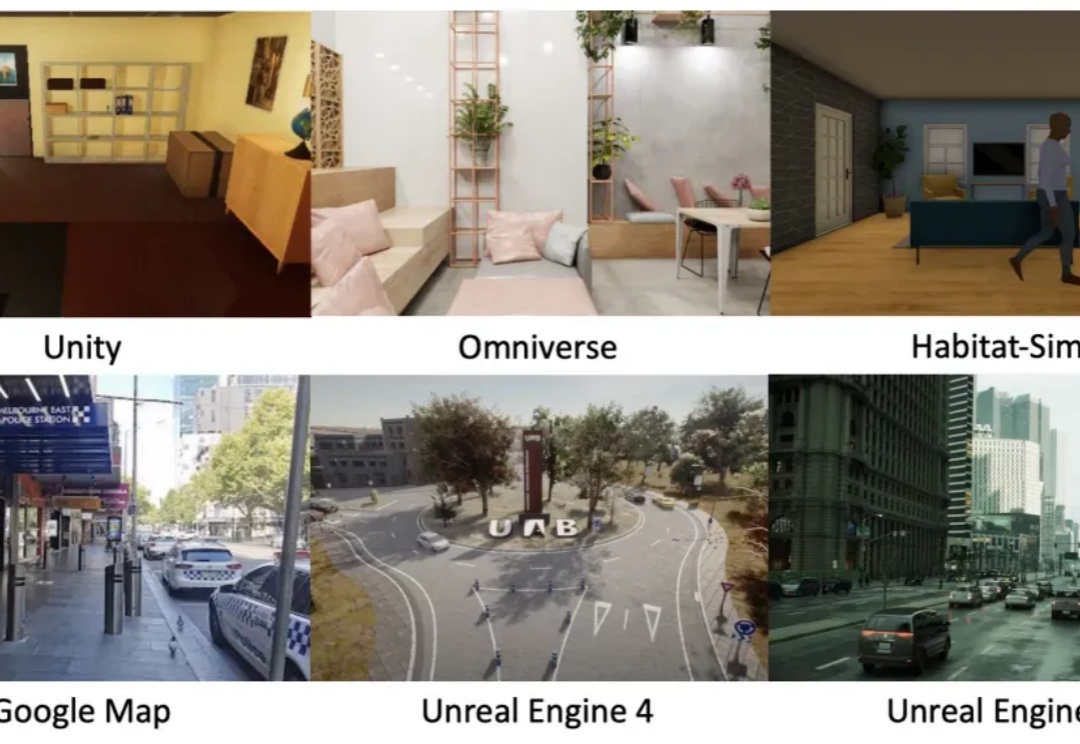

随着文图生成模型的广泛应用,模型本身有限的安全防护机制使得用户有机会无意或故意生成有害的图片内容,并且该内容有可能会被恶意使用。现有的安全措施主要依赖文本过滤或概念移除的策略,只能从文图生成模型的生成能力中移除少数几个概念。

羡慕现在搞AI的大家。去一下学术顶会,工作机会现场就来了。是的,大厂AI招聘的风,已经吹到ICCV 2025。而今年的ICCV一逛,我们还真看到了点不一样的花活——顶会直聘。

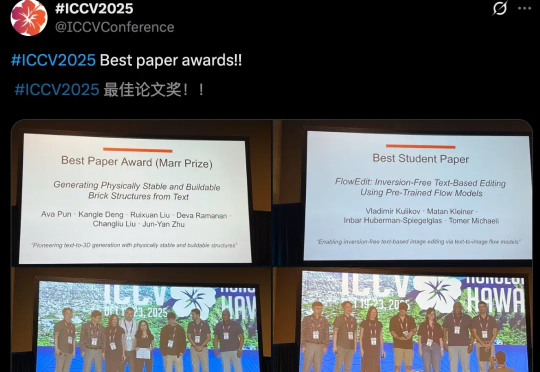

ICCV最佳论文新鲜出炉了!今年,CMU团队满载而归,斩获最佳论文奖和最佳论文提名。同时,何恺明团队论文,RBG大神提出的Fast R-CNN,十年后斩获Helmholtz Prize,实至名归。

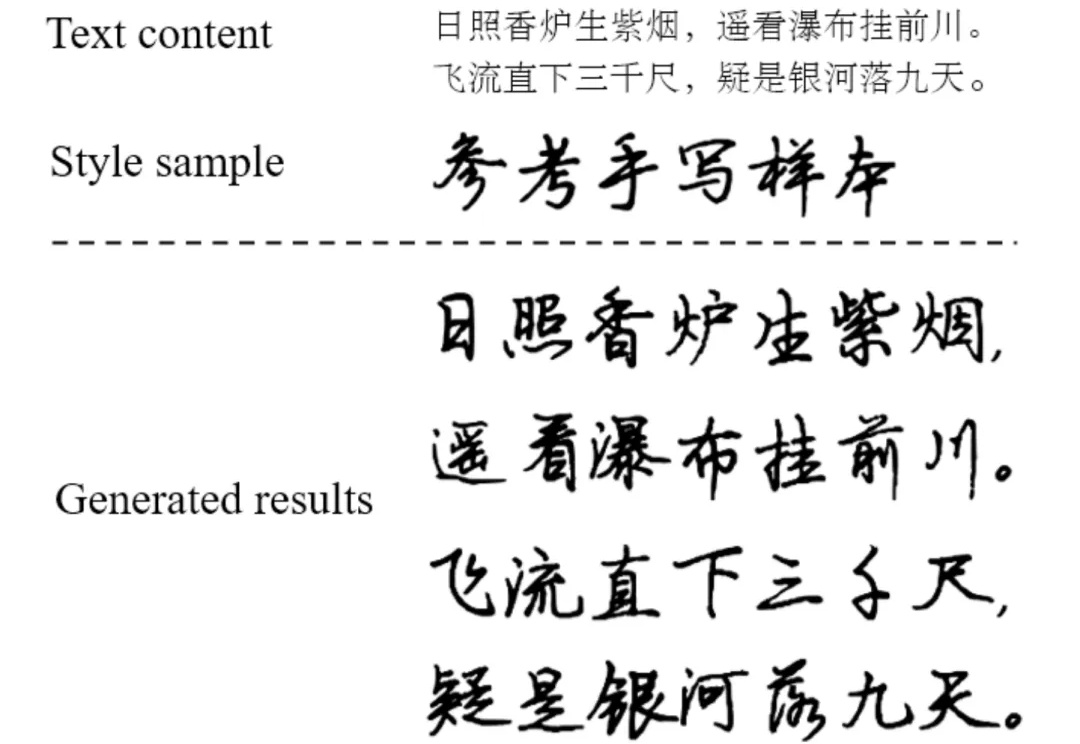

AI 会写字吗?在写字机器人衍生换代的今天,你或许并不觉得 AI 写字有多么困难。

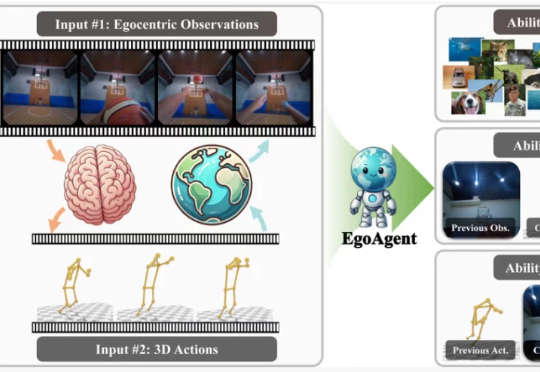

具身智能落地迈出关键一步,AI拥有第一人称与第三人称的“通感”了!

在今年的国际计算机视觉大会(ICCV 2025)上,来自浙江大学、香港中文大学、上海交通大学和上海人工智能实验室的研究人员联合提出了第一人称联合预测智能体 EgoAgent。

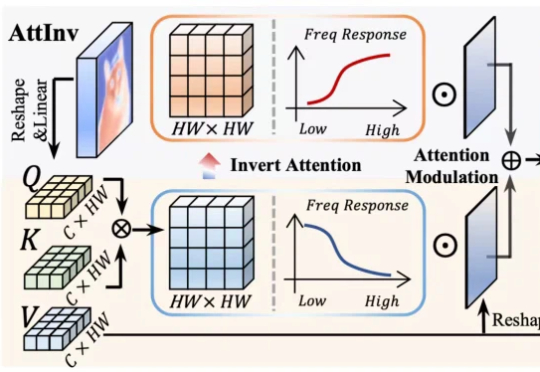

针对视觉 Transformer(ViT)因其固有 “低通滤波” 特性导致深度网络中细节信息丢失的问题,我们提出了一种即插即用、受电路理论启发的 频率动态注意力调制(FDAM)模块。它通过巧妙地 “反转” 注意力以生成高频补偿,并对特征频谱进行动态缩放,最终在几乎不增加计算成本的情况下,大幅提升了模型在分割、检测等密集预测任务上的性能,并取得了 SOTA 效果。